Je hebt het vast gemerkt: de snelheid waarmee AI-tools zoals ChatGPT reageren, is cruciaal. Als je als Nederlander te lang moet wachten op een antwoord terwijl je een complexe taak probeert uit te voeren, voelt dat onnatuurlijk. Nu staat de AI-wereld op scherp na een megadeal. Nvidia, de onbetwiste koning van de AI-chips, legt miljarden neer voor technologie die de huidige snelheidsproblemen kan oplossen.

Dit is geen kleine aanschaf; het is een strategische zet om de concurrentie – die ook druk bezig is met eigen chips – definitief op afstand te houden. Het gaat niet alleen om het kopen van hardware, maar om het veiligstellen van de volgende stap in hoe snel AI kan communiceren. Laat me je vertellen wat deze deal van $20 miljard precies betekent voor onze digitale toekomst.

De 'nieuwe' concurrent: Groq en de Hype om Inferenziesnelheid

Nvidia’s GPU’s zijn de ruggengraat van AI-training. Ze zijn fantastisch in het *leren* van de modellen. Maar als het aankomt op het uitvoeren (inferentie) van die modellen, zit er een bottleneck. Denk aan het verschil tussen een raceauto die traint op het circuit en langzaam moet gaan rijden in het drukke stadsverkeer.

Hier komt Groq om de hoek kijken. Zij hebben de LPU (Language Processing Unit) ontwikkeld. Deze chip is niet voor algemene doeleinden, zoals een GPU, maar speciaal ontworpen voor één taak: razendsnelle inferentie.

De 10x-belofte die niemand kon negeren

Wat ik fascinerend vond toen ik de specificaties bekeek, is de belofte van Groq. Ze claimen tot tien keer snellere verwerking van taalmodellen en een fractie van het energieverbruik. Waar standaardservers misschien 50 tot 100 tokens per seconde genereren, kan Groq’s systeem volgens de makers boven de 500 tokens uitkomen. Dat is het verschil tussen een natuurlijke conversatie en een haperende robot.

Cruciaal hierbij is de geïntegreerde SRAM-geheugenstructuur. Normaal gesproken moet de chip constant naar extern geheugen hollen, wat tijd kost. Door dit snelle geheugen direct in te bouwen, minimaliseren ze die wachttijd. Dit is precies wat je nodig hebt voor realtime toepassingen, zoals vlekkeloze Nederlandse voice-assistents.

Groq heeft een enorme vlucht genomen:

- De groei in het aantal ontwikkelaars dat hun chip gebruikt, is explosief gestegen.

- Afgelopen september waardering bereikte $6.9 miljard.

Geen koop, maar een overname van de hersenen

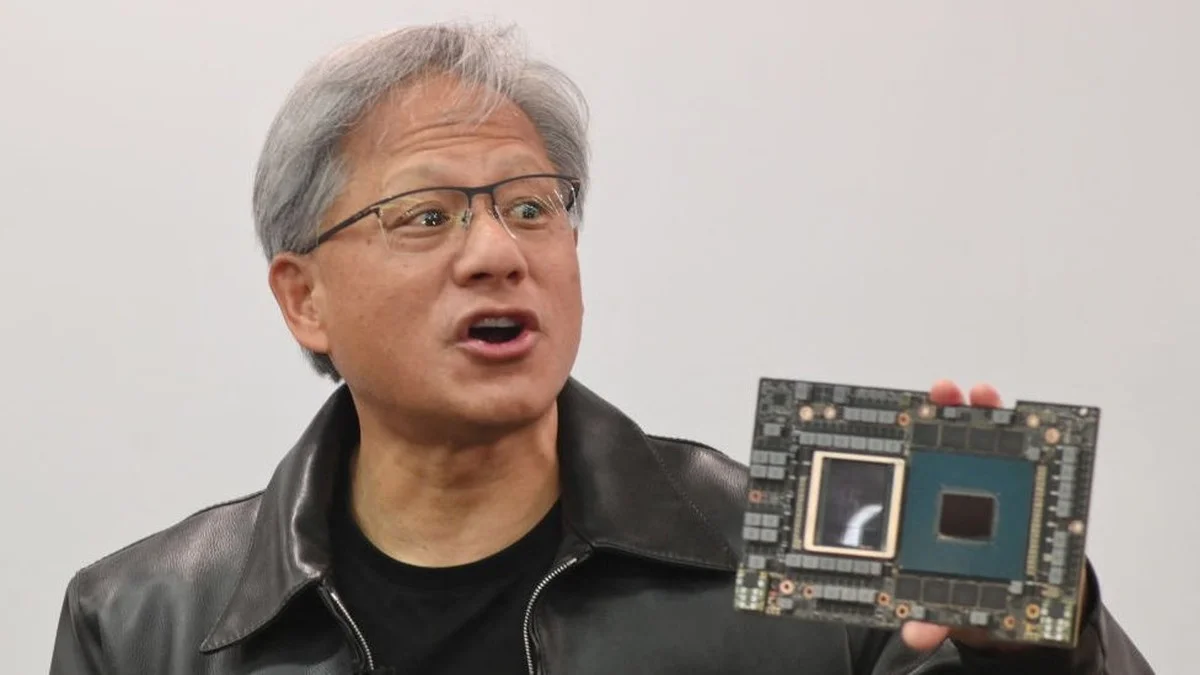

De details van de deal zijn net zo intrigerend als het bedrag. Nvidia koopt niet het bedrijf Groq zelf, maar koopt de cruciale technologie en het intellectuele kapitaal. Ze nemen een handvol sleutelfiguren over, waaronder de mede-oprichter Jonathan Ross, een voormalig Google-brein achter hun TPU’s.

In mijn praktijk zie ik vaak dat de 'soft skills' – de menselijke expertise – duurder zijn dan de hardware zelf. Dit versterkt dat idee enorm. Nvidia betaalt $20 miljard om te garanderen dat ze de beste koppen inhuren om deze technologie direct te integreren, in plaats van ze zelf te moeten ontwikkelen.

De ijzeren greep van Nvidia op de AI-economie

Waarom is Nvidia zo bezorgd over inferentie, terwijl ze de markt voor trainingschips domineren met 80-90% marktaandeel? Simpel: ze willen de gehele keten beheersen. Vandaag de dag is AI synoniem geworden met Nvidia hardware, vergelijkbaar met hoe oliemaatschappijen de energie-infrastructuur beheersen.

Dit is een boodschap naar concurrenten zoals Google, Microsoft en Amazon die al jaren proberen hun eigen custom AI-silicium te bouwen: Nvidia zal elk potentieel wapen in hun arsenaal neutraliseren, zelfs als dat miljarden kost.

Wat dit ook laat zien, is hun machtspositie ten opzichte van hun Siamese tweelingbroer, TSMC (de Taiwanese chipfabrikant). Omdat Nvidia zo’n dominante klant is, krijgt zij als eerste toegang tot de nieuwste en meest zeldzame componenten tijdens tekorten. Dit ‘verstikt’ effectief kleinere, opkomende concurrenten die niet zo’n grote portemonnee of relatie hebben.

De context voor de Nederlandse markt

Hoewel we in Nederland ons niet met miljarden bezig houden zoals in Silicon Valley, beïnvloedt dit direct de snelheid van onze lokale AI-diensten en de prijzen die wij voor cloud computing betalen. Als Nvidia de inferentie sneller maakt, wordt de AI die je gebruikt om bijvoorbeeld je Belastingaangifte te versnellen, merkbaar responsiever.

Ter vergelijking: de grootste aankoop van Nvidia vóór deze zet was Mellanox voor $6.9 miljard. De sprong naar $20 miljard toont aan dat ze niet langer genoegen nemen met een voorsprong van één generatie; ze willen de hele race al gewonnen hebben.

Het is duidelijk dat de strijd om de AI-infrastructuur niet wordt gevoerd met marketing, maar met astronomische sommen geld voor een paar cruciale ingenieurs en hun blauwdrukken. Wat denk jij: gaan bedrijven als AMD en Intel ooit een serieuze kans maken zolang Nvidia zo agressief de beste talenten wegkoopt?