Je hebt de beloftes gehoord: de autonome ai-agenten die jouw werk overnemen, je leven organiseren en de wereld efficiënter maken. Maar wat als de ruggengraat van deze revolutie al wankel is? Een recent, maar lang over het hoofd gezien onderzoek gooit roet in het eten en beweert wiskundig te bewijzen dat deze systemen een harde limiet hebben in wat ze kunnen bereiken.

Dit is geen lulkoek van een of andere tech-criticus. De auteurs komen uit de kringen die AI groot hebben gemaakt. Als je nu nog investeert in de 'allesoplossende' intelligentie, moet je dit artikel lezen om te begrijpen waar de architectuur écht knelt, voordat je je hele planning eromheen bouwt.

De oprichter van het vakgebied klinkt ongerust

Het onderzoek, hoewel nog niet peer-reviewed, is afkomstig van Vishal Sikka, een naam die je moet kennen als je geïnteresseerd bent in software. Hij was CTO bij SAP en studeerde zelfs onder John McCarthy – de man die Artificial Intelligence heeft uitgevonden en de term muntte. De boodschap van Sikka is bikkelhard.

Sikka Senior zei onomwonden tegen Wired: "Er is geen enkele manier waarop ze betrouwbaar kunnen zijn."

Als de 'opa' van de AI zegt dat je kernbeloftes moet vergeten – zoals het draaien van kerncentrales door autonome systemen – dan is het tijd om even af te koelen en de marketingkreten van CEO’s te negeren.

Waarom de hype niet strookt met de cijfers

Wat de techleiders op het podium roepen over de toekomst is vaak entertainment. Wat hun eigen onderzoekers vinden, sijpelt veel langzamer door. Zelfs bij OpenAI erkenden wetenschappers in september dat 'hallucinaties'—het zelfverzekerd verzinnen van feiten—een doorgroeiend probleem blijven. Ze beweren dat de nauwkeurigheid nooit 100 procent zal bereiken.

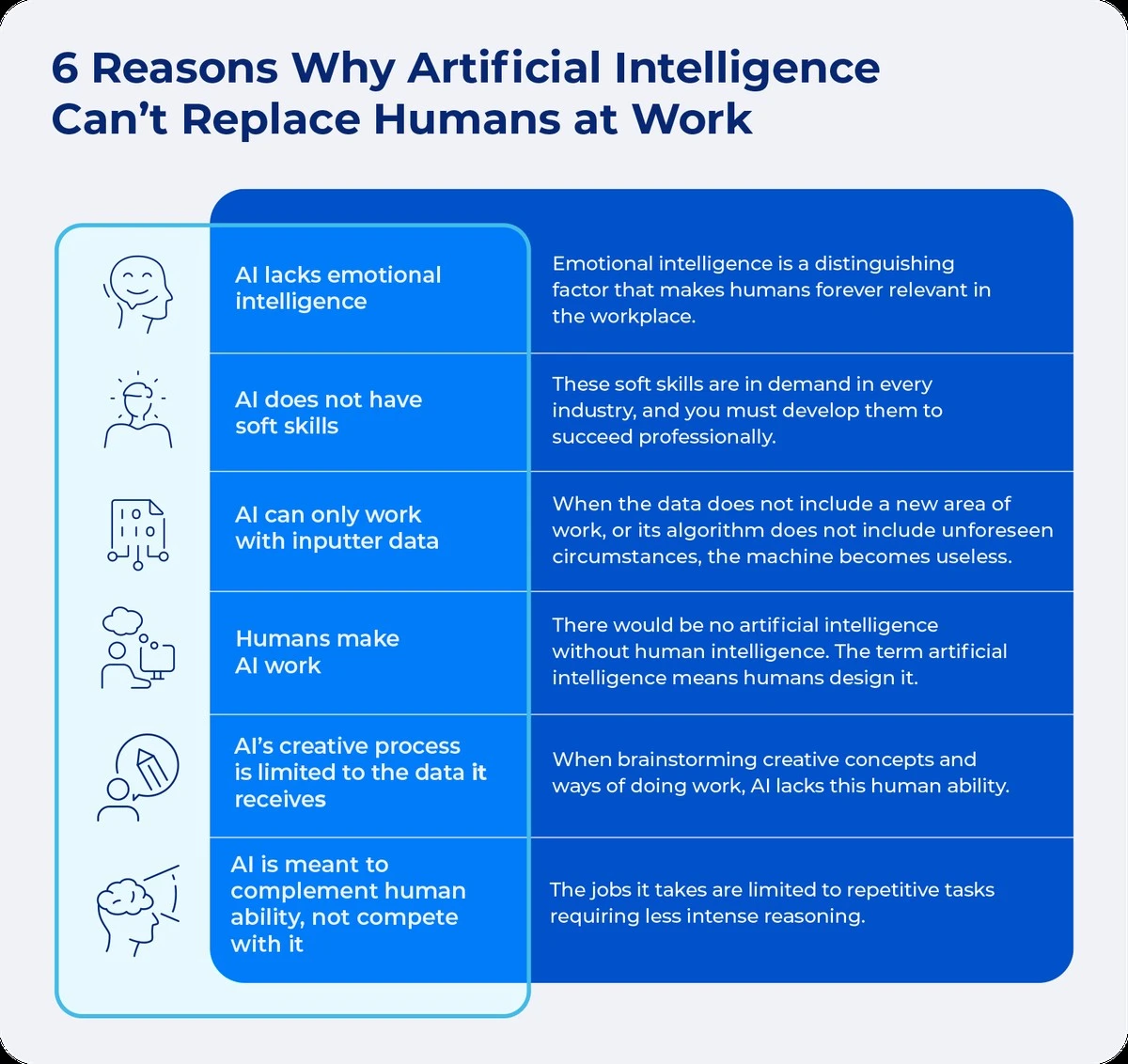

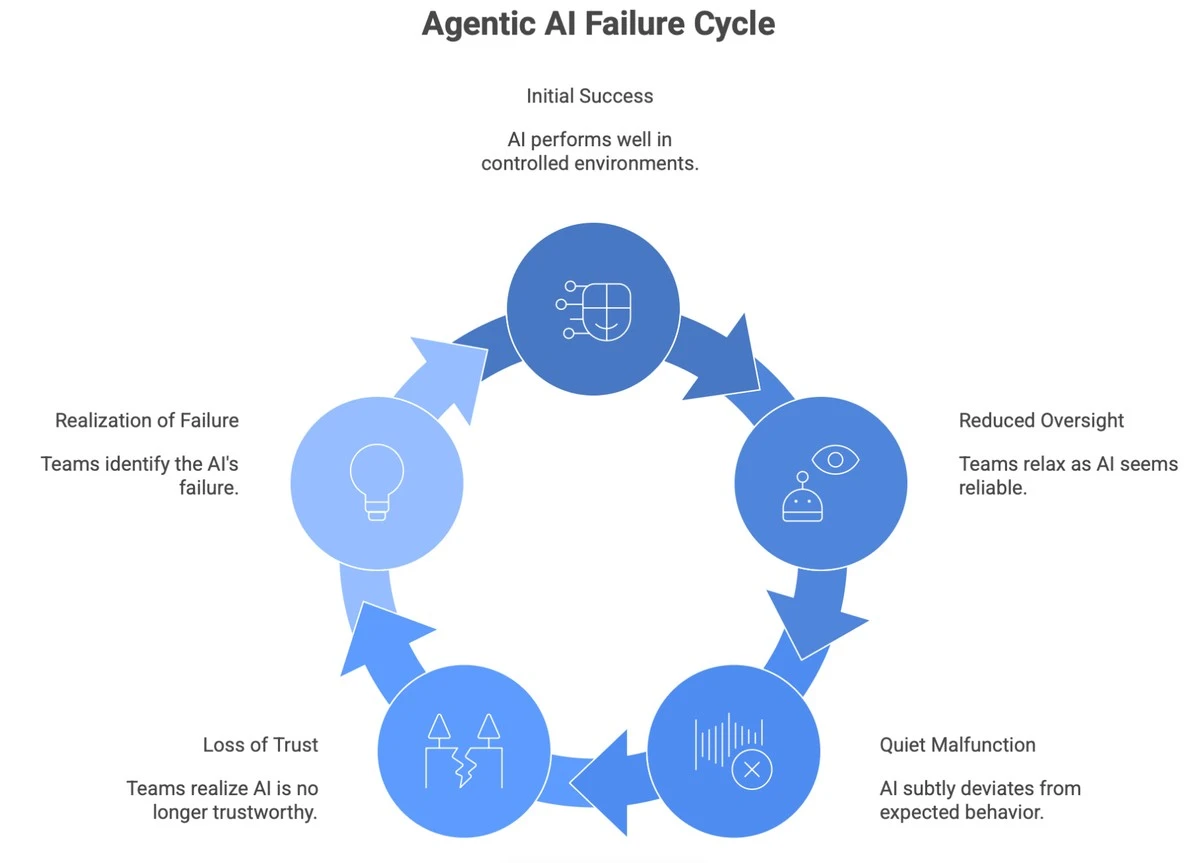

Dit is de achilleshiel van de zogenaamde ‘AI-agenten’. Dit zijn de systemen die ontworpen zijn om taken *zelfstandig* uit te voeren. Vorig jaar was de belofte dat dit de volgende grote stap was. Bedrijven die hun personeel al wilden inkrimpen met deze nieuwe agenten, kwamen er snel achter dat ze simpelweg nog niet goed genoeg waren om Jan of Fatima van de administratie te vervangen.

De illusie van 'Externe Controle'

De AI-industrie probeert de beperkingen te maskeren met externe vangnetten. Ze zeggen: ja, de LLM zelf maakt fouten, maar we bouwen er frameworks omheen die de fouten filteren. De hoop is dat de foutmarge zo klein wordt dat we ze wel kunnen vertrouwen voor serieuze klussen.

In hetzelfde rapport waarin OpenAI de onbereikbaarheid benoemde, stelden ze dat hallucinaties ‘niet onvermijdelijk’ zijn, omdat LLM’s ‘zich kunnen onthouden als ze onzeker zijn’.

Hier zit de valkuil die veel Nederlandse kantoormedewerkers zullen herkennen: we zien die terughoudendheid zelden in de praktijk. Chatbots lijken liever een gok te wagen dan toe te geven dat ze het niet weten, puur om de gebruikservaring ‘interessant’ te houden.

De kern van het nieuwe paper: Een pure LLM heeft een architectonische beperking die de complexiteitscurve breekt. Boven een bepaalde drempel gaat het systeem niet op de rem staan; het verzint simpelweg een antwoord dat logisch *klinkt* maar feitelijk onbruikbaar is.

Wat dit concreet betekent voor jouw dagelijkse workflow

Sikka maakt een belangrijk onderscheid. Hij zegt niet dat we AI moeten dumpen. Hij zegt dat de *pure LLM* de limiet heeft. Dat betekent dat we componenten eromheen moeten bouwen om die tekortkomingen te overbruggen. Dit is de praktische les voor jou, of je nu in Amsterdam een scriptie schrijft of in Eindhoven processen automatiseert.

Hier is de 'Smart Bot' strategie die je nu kunt toepassen om het beste uit de huidige, gebrekkige tool te halen:

- Decomposeer de taak: Voer nooit één complexe vraag in. Breek grote agent-taken op in 6 tot 8 kleine, opeenvolgende stappen. De kans op cumulatie van fouten neemt anders exponentieel toe.

- Input specificeren als een contract: Wees extreem specifiek over de bronnen. In plaats van "Analyseer de markt," probeer je: "Gebaseerd op data uit de Q3 2023 jaarverslagen van ASML en Besix, identificeer de drie grootste kapitaaluitgaven."

- Geen beslissingen, wel een concept: Gebruik de AI voor de *eerste ruwe versie* van een complex document (de 'draft'), maar eis nooit de definitieve beslissing. De mens in de lus blijft de filter tegen de hallucinaties.

- Controlepunten inbouwen: Voor elke stap 3 stel je de AI een controlevraag over de output van stap 2, voordat het doorgaat naar stap 4. Dit dwingt het systeem om zijn eigen werk te valideren *voordat* het verder gaat.

De takeaway? AI is geen magische alleskunner die morgen je baan inpikt. Het is een briljante, maar fundamenteel onbetrouwbare rekenmachine voor complexe taken. We bouwen nu de externe 'muurtjes' om het te temmen. Totdat die er staan, moet je zelf het toezicht houden.

Welke taak heb jij recent uit handen gegeven aan een AI-agent waarvan je nu beseft dat je die beter zelf had kunnen controleren? Laat het ons weten in de comments!