Heb je ooit geprobeerd een extreem lange handleiding of een compleet jaarverslag in een AI-tool te plakken, om vervolgens een vaag antwoord terug te krijgen? Je bent niet de enige. De meeste modellen lijken een geheugen van een goudvis zodra je de limiet van een paar duizend woorden bereikt. Dit is pijnlijk als je werkt met juridische documenten of complexe code.

Maar onderzoekers van MIT CSAIL hebben een doorbraak geforceerd die het speelveld verandert. Ze hebben een methode ontwikkeld waarmee AI gigantische hoeveelheden tekst – miljoenen woorden – kan verwerken zonder dat het model opnieuw getraind hoeft te worden. Dit is geen kleine update; dit is hoe we in de toekomst met écht lange documenten gaan werken.

Het bekende probleem: de geheugenbuffer is vol

De meeste grote taalmodellen werken met een ‘context window’. Zie dit als het werkgeheugen van een computer. Als je te veel programma's tegelijk opent (te veel tekst invoert), begint de computer te haperen, of crasht hij simpelweg. Bij AI stoppen de modellen met ‘onthouden’ wat je aan het begin van het document zei.

In de praktijk betekende dit dat we complexe analyses moesten opdelen in hapklare brokken. Zelfs al hielp je het model door het in stukjes aan te leveren, het verloor het overzicht. Dit is de reden waarom jouw poging om een heel script door GPT te laten analyseren vaak faalt.

De truc van MIT: de recursieve aanpak

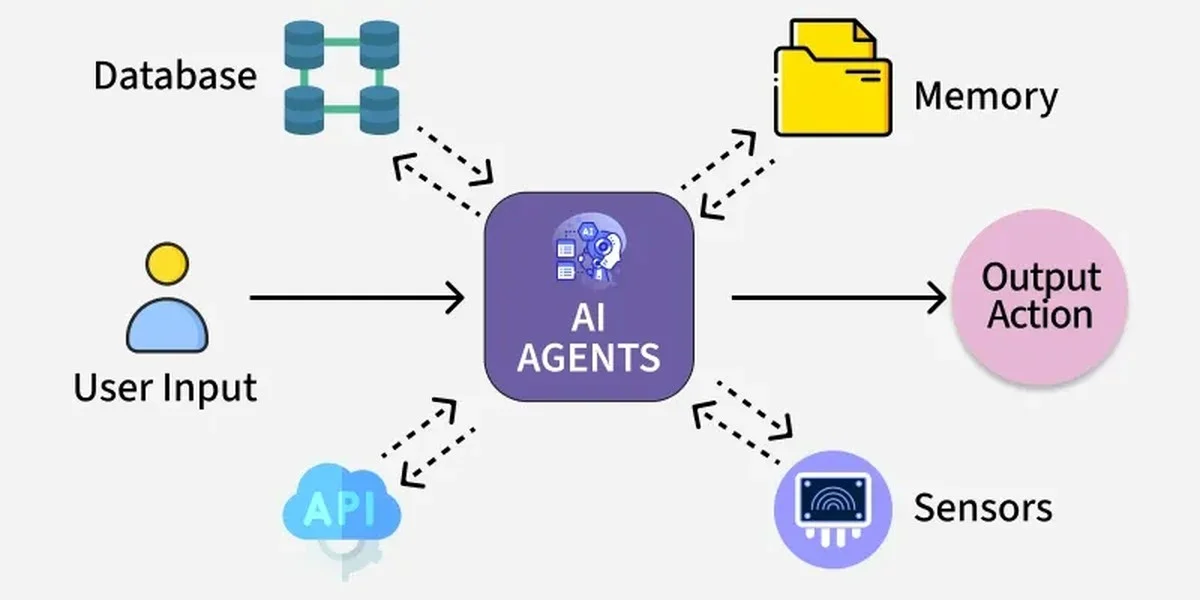

De oplossing van het MIT-team heet RLM (Recursive Language Model). Het geniale zit in de splitsing van de taken. In plaats van het hele document in één keer te forceren, doen ze het slim:

- De Planner (Hoofdmodel): Een krachtig model (zoals GPT-5) krijgt slechts een overzicht van het document: hoeveel hoofdstukken, hoeveel stukken er zijn. Het schrijft vervolgens code.

- De Uitvoerder (Werkmodel): Dit snellere, lichtere model voert de code uit. Het haalt stukje voor stukje informatie uit de externe opslag.

Het hoofdmodel laadt dus nooit het hele, gigantische document in zijn werkgeheugen. Het vraagt de werker om specifieke fragmenten te halen en te analyseren, net zoals een programmeur een groot bestand in segmenten leest.

De cijfers liegen er niet om

Toen ze RLM testten op complexe taken waar standaardmodellen keer op keer faalden, werden de resultaten verbazingwekkend. Ik heb de resultaten bekeken, en ze zijn indrukwekkend:

- Op een benchmark voor het vinden van precieze informatie (BrowseComp-Plus) scoorde RLM 91% correcte resultaten. Het standaardmodel? Nul komma nul.

- Bij complexe redenering over meerdere stappen (OOLONG-Pairs) verbeterde RLM de score van 0,04% naar 58% correcte oplossingen.

Dit betekent dat AI nu echt complexe coderingen of meerlagige contracten kan doorgronden. Dit is cruciaal voor ontwikkelaars die door miljoenen regels code moeten spitten.

Praktische waarde: wat betekent dit voor jou?

Hoewel dit klinkt als verre toekomstmuziek, is de implementatie verrassend direct. Het RLM-systeem is zo ontworpen dat het naadloos kan integreren met bestaande architecturen, zoals RAG (Retrieval-Augmented Generation). Dit betekent dat jouw huidige tools, mits ze slim genoeg zijn aangepast, dit geheugenprobleem kunnen omzeilen.

De belangrijkste les hier is: de limiet lag niet in de intelligentie van het model, maar in hoe we het de informatie aanleverden. Stel je voor dat je een ambtenaar in Nederland een dossier van vijftien archiefdozen geeft zonder duidelijke inhoudsopgave. Hij faalt. Geef je hem een zoekopdracht en laat je hem per doos zoeken, dan slaagt hij. RLM is die efficiënte zoekassistent.

En het mooie? De makers hebben de code op GitHub gezet. Dit betekent niet alleen dat de prestaties van grote modellen stijgen, maar ook dat de kosten beheersbaar blijven, omdat we niet de hele kern van het model telkens opnieuw hoeven te trainen.

Uiteindelijk lost dit een fundamentele beperking van LLM's op. Wat is volgens jou de eerste taak die jij een AI met bijna oneindig geheugen zou geven? Laat het weten in de comments!