Je gebruikt ChatGPT of Gemini dagelijks. Je stelt vragen, je vraagt om samenvattingen. Maar de resultaten zijn vaak middelmatig, of je moet eindeloos bijsturen. Het verschil tussen een standaardantwoord en een baanbrekende output zit hem niet in het model, maar in jouw aanpak.

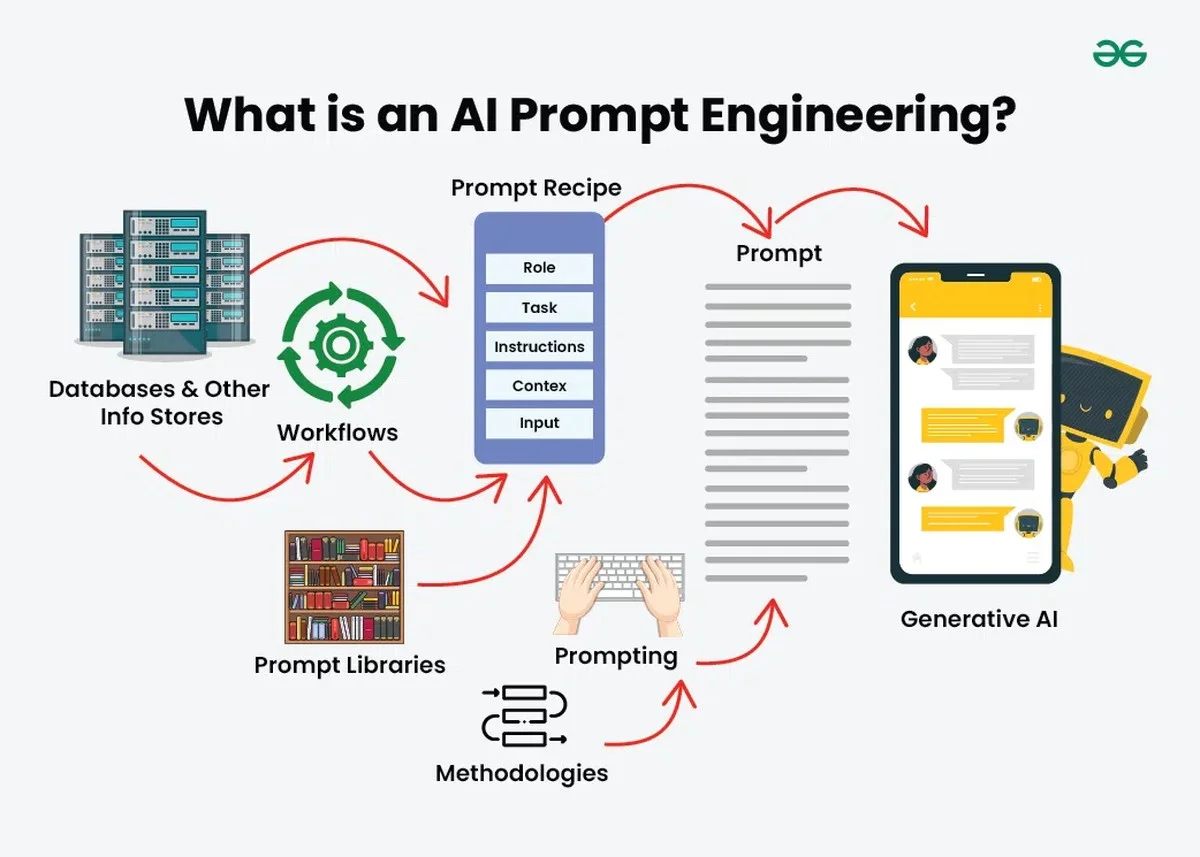

Degenen die het uiterste uit AI halen, bezitten een expertise die men 'Prompt Engineering' noemt. Dit is geen luxe, maar een basisvaardigheid geworden. Ik ontdekte dat de échte efficiëntie-boost – de zogenaamde tienvoudige productiviteit – komt door een paar structurele fouten te vermijden en specifieke 'motoronderdelen' in de prompt te bouwen.

Waarom je huidige prompts een kapotte koffiefilter zijn

Veel mensen behandelen AI als een vriendelijke assistent die hun gedachten kan lezen. Dit werkt niet. AI is machtig, maar heeft sturing nodig. De Engelse term 'engineering' benadrukt dat dit proces herhaalbaar en gestructureerd moet zijn, niet willekeurig.

In mijn testen met zowel Gemini voor YouTube-samenvattingen als met ChatGPT zag ik dezelfde valkuilen:

- Te algemene vragen leiden tot vaag, generiek taalgebruik.

- Het negeren van de 'spelregels' van het model (de 'grondwet').

- Verwachten dat AI jouw unieke bedrijfstermen wél snapt zonder context.

De mythe van de kant-en-klare sjabloon

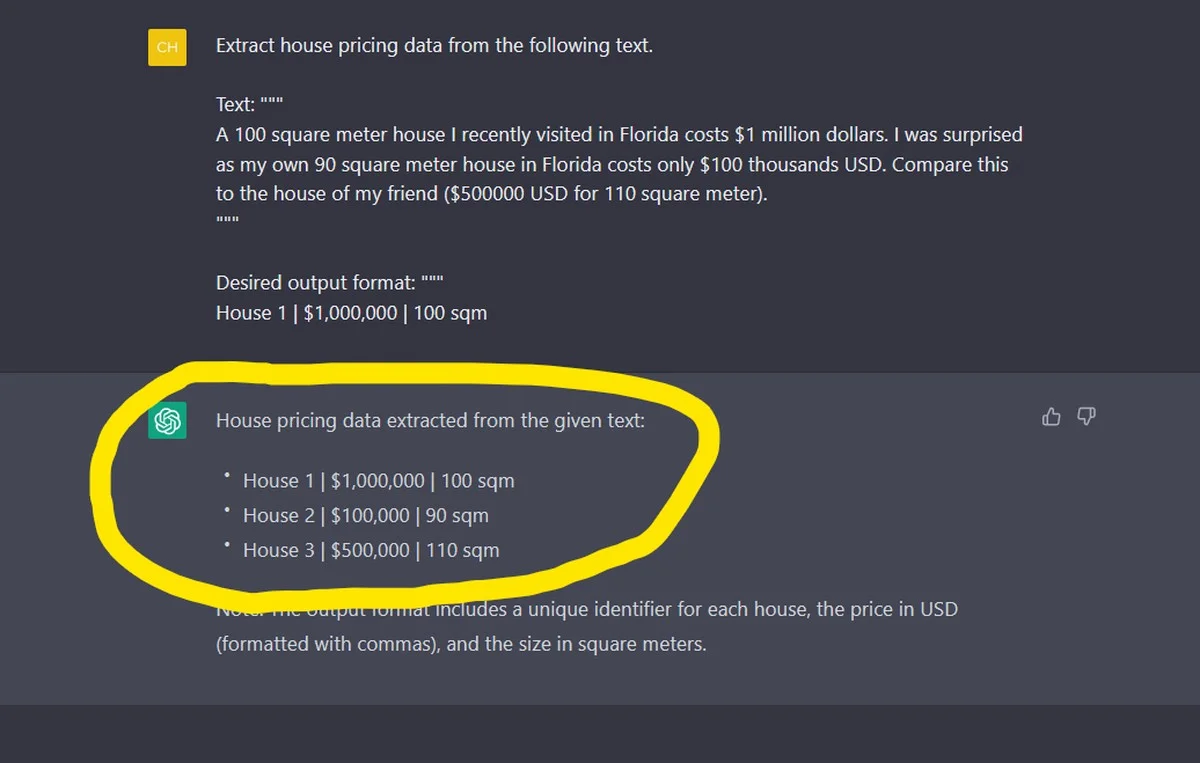

Online circuleren talloze 'magische' prompt templates. Het domweg kopiëren hiervan is net zo nutteloos als een recept kopiëren zonder de ingrediënten te begrijpen. Je moet de individuele sleutelwoorden testen.

Kijk bijvoorbeeld naar de opdracht "Let's think step by step". Dit is een simpele zin, maar het dwingt de AI om eerst een logische route uit te stippelen, wat de complexiteit van de output drastisch verhoogt. Je moet begrijpen waarom elk woord werkt.

De Drie Geheimen voor God-Tier Prompts

Nadat ik honderden prompts had geanalyseerd, destilleerde ik drie technieken die de kwaliteit van de output exponentieel verhoogden, ongeacht of ik met Claude of Gemini werkte.

1. Doe de AI een vooronderzoek (Meta-Prompting)

Dit is het stukje dat de meeste mensen overslaan. Als je niet zeker weet hoe je jouw complexe taak het beste kunt formuleren, laat de AI je helpen de vraag te structureren. Dit is een briljant trucje voor de Nederlandse markt, waar nauwkeurigheid hoog in het vaandel staat.

In plaats van direct de inhoud te vragen, geef je de AI eerst deze opdracht:

- "Ik wil een analyse van de recente BTW-wijzigingen voor zzp’ers. Ik weet niet of mijn instructies duidelijk zijn. Stel mij eerst 3 tot 5 verhelderende vragen om mijn doelstellingen scherper te krijgen. Antwoord nog niet op de inhoud."

Nadat de AI vragen stelt, beantwoord je deze. De output die volgt, is exponentieel nauwkeuriger, omdat je de AI hebt laten fungeren als jouw senior projectmanager.

2. Gebruik de 'Twee Ramen' Compareer-methode (AB-testen)

AI is inherent willekeurig. Soms genereert GPT-4o een meesterwerk, en de volgende keer een matige tekst. Om stabiliteit te garanderen, test je je hypotheses.

Open twee vensters. Gebruik bijvoorbeeld Gemini in het ene venster om een conceptversie van een prompt voor ChatGPT te schrijven, terwijl je in het andere venster die prompt direct test in ChatGPT. Vergelijk de resultaten. Zo ontdek je welke roltoewijzing (bijvoorbeeld 'Ervaren redacteur van NRC' versus 'Student eerstejaars') beter werkt voor jouw specifieke taak. Je moet het zien om het te geloven.

3. Ken de Hiërarchie: De 'Grondwet' van de AI begrijpen

Elke AI heeft een System Prompt: de onzichtbare 'grondwet' die bepaalt wat het model wel en niet mag doen. Dit is de hoogste autoriteit.

Voor de gewone gebruiker is dit vooral belangrijk om te weten waarom AI soms weigert:

- Stel je vraagt de AI om een controversieel opiniestuk te schrijven. Het antwoord is vaak een weigering, omdat de 'grondwet' (System Prompt van de leverancier) dit ethisch verbiedt.

- Bedrijven die API’s gebruiken, kunnen hier hun eigen 'grondwet' invoeren om te voorkomen dat hun klantenservice-AI plotseling onprofessioneel gaat klinken, zelfs als de gebruiker dit probeert uit te lokken.

De Toekomst: Van Volgen naar Denken

We verschuiven van Large Language Models (LLM's) naar Reasoning Models. Vroegere modellen waren als een stagiair die je elke stap moest dicteren. Nieuwe iteraties zijn als een ervaren collega die eerst de strategie plant en dan pas uitvoert.

De volgende stap is de Agentic Workflow: AI dat niet één keer output levert, maar een cyclus van uitvoeren, reflecteren en corrigeren doorloopt. Dit betekent dat je minder moet sturen op 'hoe', en meer op 'wat' je wilt bereiken.

Welke van deze drie technieken – Meta-Prompting, AB-testen of het begrijpen van de System Prompt – ga jij morgen als eerste toepassen op je dagelijkse AI-taken?