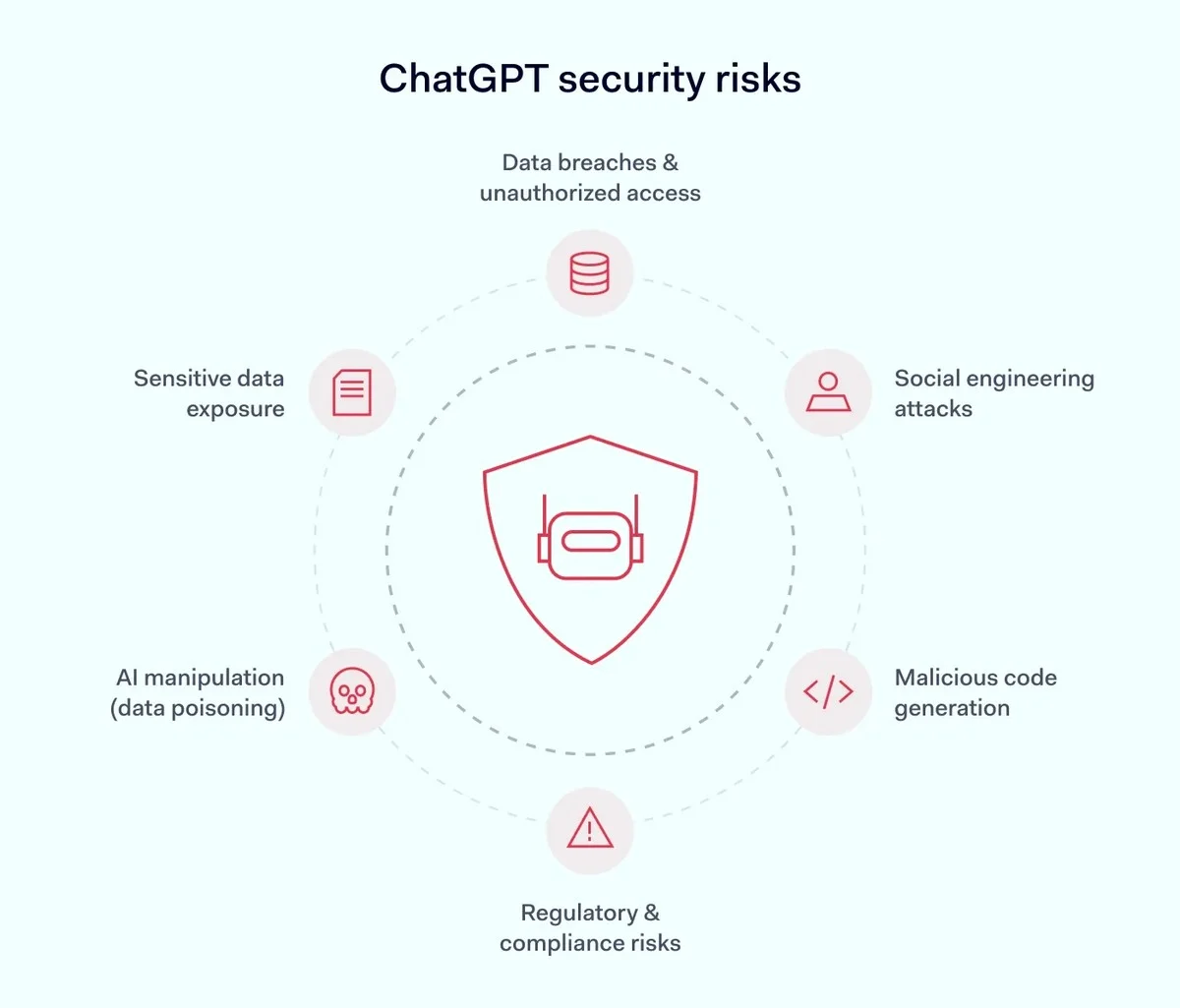

Je gebruikt het waarschijnlijk al om sneller een conceptmail op te stellen of die ingewikkelde handleiding samen te vatten. De populariteit van tools als ChatGPT, Gemini en Copilot is explosief; het voelt inmiddels bijna alsof iedereen ze gebruikt. Maar terwijl je deze wonderlijke tool inzet om je dagelijks leven makkelijker te maken, sluimert er een groot risico.

Een recente analyse toonde aan dat de data die jij invoert, niet zomaar verdwijnt. In veel gevallen wordt het onbeperkt bewaard en gebruikt om de modellen verder te trainen. Dit is geen kleine schoonheidsfout; experts waarschuwen dat je jouw digitale leven onbewust in de etalage zet. Hieronder bespreken we precies welke vijf stukjes informatie je te kostbaar zijn om weg te geven, en wat je moet doen als je die fout al gemaakt hebt.

De Aanname van Privacy: Waarom je AI behandelt als een dagboek

We praten tegen ChatGPT zoals we dat tegen een menselijke collega of een privé-therapeut zouden doen. Dat gevoel van veilige conversatie is echter misleidend. Veel gebruikers realiseren zich niet dat de ‘geheugenfunctie’ van deze AI niet onder normale privacywetgeving valt, zoals de AVG.

Een cyberbeveiligingsexpert merkte op: "De conversaties worden direct of indirect gebruikt om het toekomstige gedrag van het model te sturen. Als er persoonlijke of vertrouwelijke data in zit, is het daarna uit jouw controle." Data is op dit moment de meest waardevolle grondstof die bedrijven uit ons halen.

De Vijf Gevoelige Informatiebronnen die je moet blokkeren

1. Identiteitsdocumenten en Adresgegevens

Dit lijkt logisch, maar de verleiding is groot als je snel hulp nodig hebt bij het vertalen van een officieel document. Denk aan paspoortnummers, rijbewijsdetails of je BSN (als je die al eens hebt ingevoerd).

- Risico: Identiteitsdiefstal en zeer gerichte phishing-aanvallen.

- De nuance: Zelfs als je een bestand uploadt ter analyse, kan dat materiaal gebruikt worden voor modeltraining.

2. Medische Informatie en Gezondheidsdata

Wist je dat één op de zes volwassenen ChatGPT gebruikt voor medische vragen? Dat is een alarmerend hoog cijfer. Hoewel je misschien denkt dat je anekdotes deelt, kunnen subtiele details over je gezondheid later tegen je gebruikt worden.

Zelfs als je alleen de diagnose noemt, is er geen garantie dat de AI-aanbieder voldoet aan de strenge medische privacystandaarden. Houd medische dossiers strikt gescheiden van je AI-sessies.

3. Bedrijfsgeheimen en Broncode

Je hebt een complex nieuw algoritme geschreven en wilt dat de AI de code debugt of optimaliseert. Voordat je deze code in de prompt plakt, pauzeer. Dit geldt voor interne rapporten, financiële prognoses of klantgegevens.

Zelfs een enkele prompt met gevoelige data kan leiden tot een contractbreuk bij je werkgever, omdat je de Vertrouwelijkheidsovereenkomst (NDA) schendt. Behandel deze input als een gedeeld document in een drukke koffietent in Utrecht – iedereen kan meekijken.

4. Financiële Details en Bankgegevens

Dit is het domein van fraudeurs. Als je hulp vraagt bij het invullen van belastingformulieren of het analyseren van je jaarrekening, wees extreem voorzichtig met het kopiëren van rekeningnummers of salarisinformatie.

Het is een simpele waarheid: de data die je invoert, kun je later niet meer terugvorderen uit de trainingsdatasets van de AI.

5. Persoonlijke Gedachten en Conflicterende Relaties

Emotionele of relationele details lijken veilig, maar AI kan deze patronen blootleggen. Als je bijvoorbeeld een woede-uitbarsting of een ernstige werkspanning beschrijft, kan deze emotionele blauwdruk gebruikt worden om je toekomstige interacties te beïnvloeden, of erger nog, in een juridische context gebruikt worden als bewijs.

Wat nu? Stappenplan na het delen van gevoelige data

Als je nu paniek voelt omdat je misschien al iets te veel hebt gedeeld, is er geen paniekknop, maar wel actie die je kunt ondernemen. Ten eerste:

- Schakel Historie Uit: Ga direct naar de instellingen van je AI-tool en deactiveer de optie dat je conversaties mogen worden gebruikt voor modeltraining. Dit is de belangrijkste stap.

- Verwijder de Sessie: Hoewel dit de data niet altijd uit de achterliggende datasets haalt, is het een noodzakelijke stap om je account te beveiligen tegen mogelijke toekomstige inbreuken.

- Generaliseer: Als je een vraag moet stellen over iets specifieks, gebruik dan pseudoniemen of vervang de exacte cijfers door ruwe schattingen. Vraag je AI om een reactie op ‘een IT-manager met 15 jaar ervaring’ in plaats van je eigen naam en functie.

Behandel elke interactie met een chatbot als een semi-publieke ruimte. Vraag jezelf bij elke invoer af: "Zou ik dit durven te plaatsen in de groepschat met mijn hele familie, inclusief mijn schoonmoeder?" Zo ja, dan is het waarschijnlijk veilig genoeg. Zo nee, wees minimalistisch.

Heb jij onlangs iets gedeeld met ChatGPT waarvan je dacht dat het veilig was, maar waar je nu achteraf toch over twijfelt? Laat het ons weten in de comments. Wat is jouw persoonlijke gouden regel bij het gebruik van deze tools?