Terwijl we dachten dat AI vooral in onze telefoons en laptops zat, komt NVIDIA's Jensen Huang met een boodschap die de regels totaal herschrijft. Hij kondigde aan dat het "ChatGPT-moment" voor fysieke, tastbare robots en zelfrijdende auto's nu écht is aangebroken. Dit is geen verre toekomstmuziek meer; de technologie is er, en hij liet het zien op CES.

Waarom is dit belangrijk voor jou, zelfs als je geen ingenieur bent? Omdat de manier waarop machines leren – en dus de wereld om ons heen veranderen – fundamenteel verschuift. Als je dacht dat softwareontwikkeling al ingewikkeld was, bereid je dan voor. We gaan van *programmeren* naar *trainen* op een compleet nieuwe schaal.

De Sprong Voorbij de Tekst: Van Software naar Spieren

We zijn gewend geraakt aan het feit dat AI tekst genereert of beelden maakt. Maar Huang maakte duidelijk: de volgende golf is de "Physical AI". Dit betekent dat kunstmatige intelligentie niet alleen weet wat het moet zeggen, maar ook hoe het een object moet oppakken, een complexe manoeuvre in het verkeer moet uitvoeren, of door een rommelige magazijnvloer moet navigeren.

Vera Rubin: De Nieuwe Motor van de Hightech Industrie

Het pronkstuk was de onthulling van het langverwachte Vera Rubin rekenplatform. Dit is de opvolger van de Blackwell-chips die momenteel de AI-wereld aandrijven. Het is een combinatie van de Vera CPU en de Rubin GPU. Wat jij moet weten is dit:

- Efficiëntie is de nieuwe munt: Kosten voor AI-inferentie (het uitvoeren van taken) kunnen tot 10 keer lager uitpakken. Dat is de sleutel tot massale adoptie.

- Massaproductie gestart: De Rubin GPU is nu in volledige productie en de eerste systemen worden dit najaar uitgeleverd aan giganten als AWS en Microsoft.

- De hardwarelaag telt: Een enkel rack van dit nieuwe systeem bevat 72 Rubin GPU's en 36 Vera CPU's. Dit toont de immense rekenkracht die nodig is voor fysieke intelligentie.

Ik merkte op dat de focus duidelijk verschoven is van pure snelheid naar de combinatie van snelheid én extreme energie-efficiëntie. Dit zijn de chips die de komende jaren de datacenters draaiende houden, zelfs hier in Nederland waar energiekosten een serieuze factor zijn.

De Zelfrijdende Auto Krijgt een Brein met Alpamayo

Hoe maak je een zelfrijdende auto écht slim? Simpelweg door de wereld te laten 'zien'? Nee, hij moet kunnen *redeneren*. NVIDIA introduceerde Alpamayo, een open-source AI-model specifiek getraind voor autonome voertuigen.

Dit model is in staat om, op basis van videobeelden, tegelijkertijd de rijbaan én de *redeneerbaan* (de intentie van andere weggebruikers) te genereren. Dit is cruciaal, want een kleine fout in de perceptie kan in het verkeer fataal zijn.

De truc van 'Destillatie': Alpamayo kan fungeren als een 'expertmodel'. Ontwikkelaars kunnen de kennis van dit grote, complexe model 'destilleren' naar een kleiner, sneller model dat daadwerkelijk in de auto draait. Dit is hoe we de performance van de supercomputer naar de beperkte hardware in een voertuig krijgen.

Klaar voor de Robotica: Niet meer ‘Thema Park’

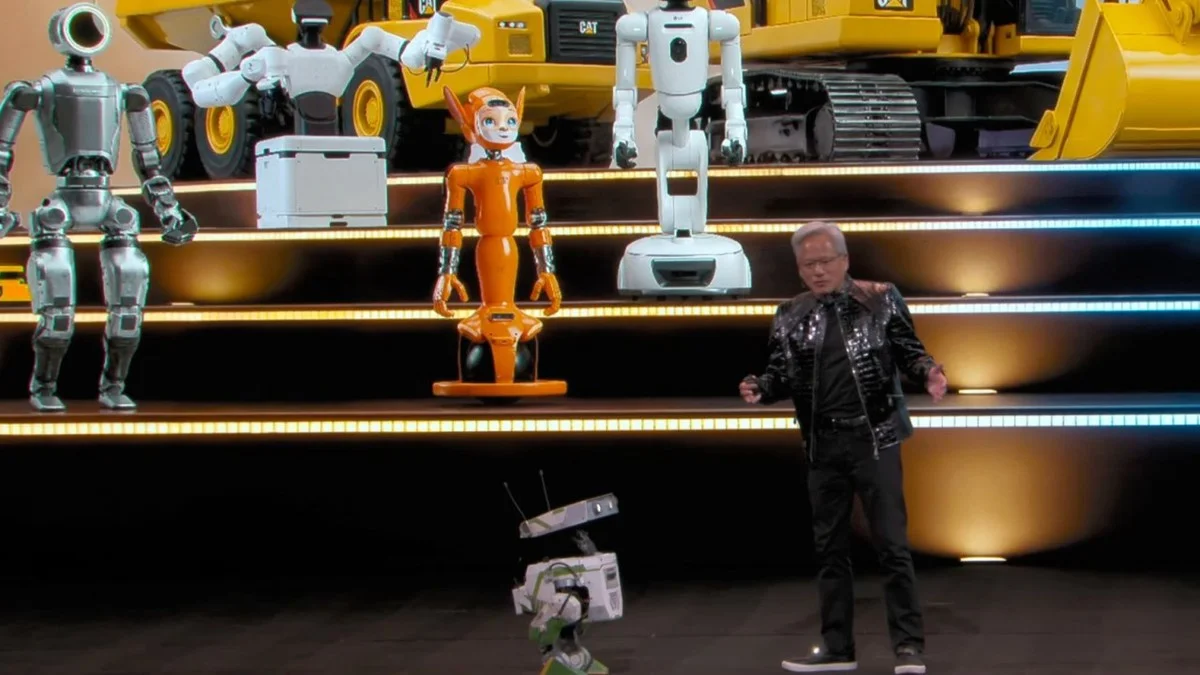

Het meest visuele deel van de presentatie was de interactie met robots. Huang stond naast een paar kleine, beweeglijke machines – ze zagen er niet uit als perfect gepolijste filmsterren, maar ze *werkten*. Dit is het bewijs dat de kloof tussen simulatie en de echte wereld kleiner wordt.

NVIDIA gebruikt daarvoor de Omniverse-omgeving, een soort digitale tweelingwereld waar robots miljarden kilometers kunnen oefenen zonder een enkele echte fabrieksband te hinderen. Zij leren daar de basisvaardigheden (greepkracht, balans, navigatie) via modellen als Cosmos en Isaac GR00T.

Mijn inzicht hierover: De echte waarde zit hem niet in het bouwen van één perfecte robot, maar in het creëren van een model dat kan leren van *elke* robot in het veld. Denk aan de logistieke centra hier in de Randstad die wachten op echte, betrouwbare hulp.

Wat dit voor jou betekent

Hoewel dit klinkt als science fiction, zie je de verschuiving al: bedrijven die software bouwen, moeten nu ook 'fysieke' AI meenemen in hun planning. De afhankelijkheid van GPU's zal alleen maar toenemen. De komende jaren wordt de vraag niet "Welke app gebruik ik?", maar "Welke actie kan de AI voor mij uitvoeren in de echte wereld?".

Bent deze nieuwe generatie AI, die de fysieke wereld begrijpt en eraan handelt, iets waar jij persoonlijk al op gewacht hebt, of maakt het je juist een beetje huiverig over de snelheid van deze verandering?