Stel je voor: je bent net de hoogste bestuurder van een prestigieuze universiteit. Je hebt AI publiekelijk gewaarschuwd dat het bronnen verzint – 'hallucinaties', noem je het. En dan, in je allereerste grote toespraak, blijkt dat je zelf afhankelijk bent van dezelfde technologie die je zojuist veroordeelde. Pijnlijk is een understatement. Dit is precies wat rector Petra De Sutter overkwam bij de Universiteit Gent (UGent).

Dit is niet zomaar een blunder; dit is een spiegel die ons voorhoudt hoe snel we de controle verliezen zodra we te veel op generatieve AI vertrouwen. Als je dacht dat je de AI-risico's al kende, lees dan verder. De nuance over ‘leading by example’ ligt hier verrassend diep.

De Ironie: De AI-adviseur die zelf valt voor AI

Toen De Sutter in september aantrad, waarschuwde ze terecht: "Veel masterthesissen worden vandaag door AI geschreven." Ze kende de regels voor haar eigen studenten en personeel: gebruik AI verantwoord, of anders krijg je verzonnen bronnen.

Maar toen kwam de praktijk. Onderzoeksplatform Apache ontdekte dat de openingsrede van de rector vol zat met citaten die simpelweg niet bestonden. Alsof je een chef-kok bent die kookboeken schrijft, maar de recepten in je eigen boek niet kloppen.

De Drie Gemaakte 'Hallucinaties'

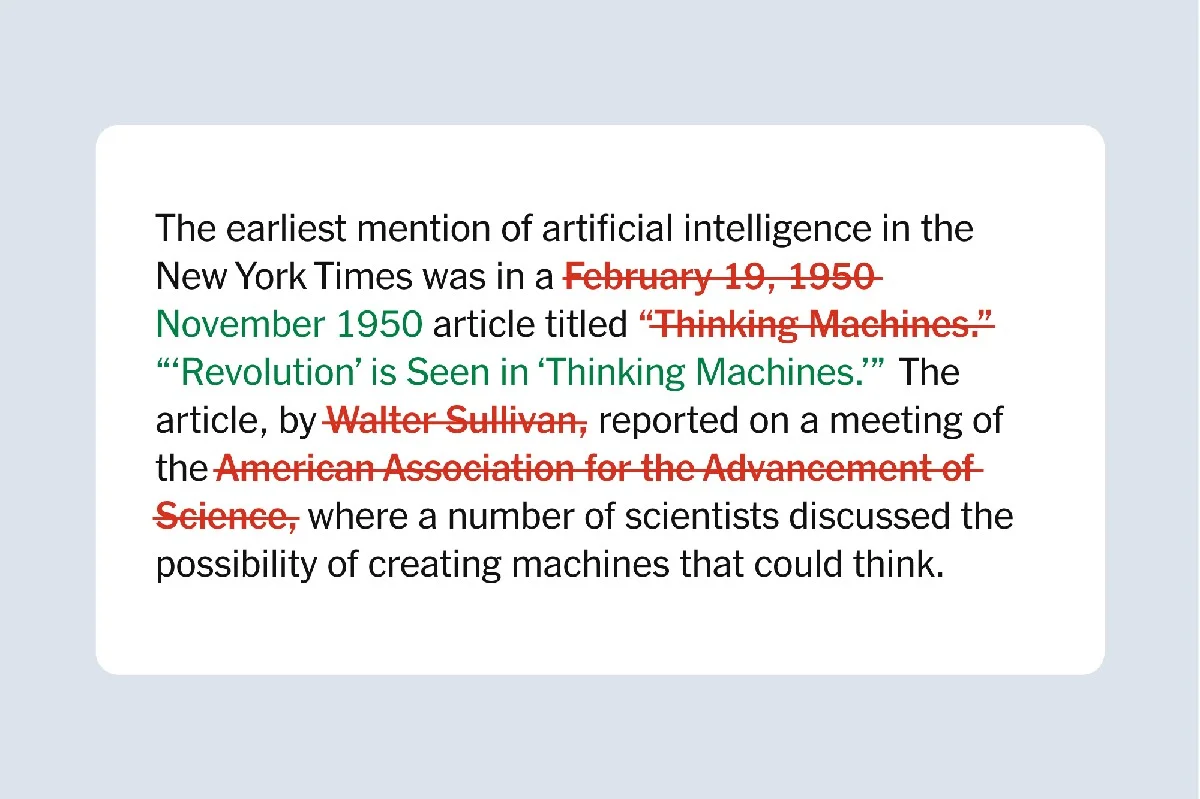

Het is fascinerend te zien hoe AI de meest overtuigende leugens kan verzinnen. De Sutter schreef de fouten - na een onderzoek - publiekelijk toe aan generatieve AI. Hier zijn de opmerkelijke 'verzonnen' citaten:

- Einstein bij de Sorbonne (1929): Een klassieker werd toegeschreven aan Einstein, maar de datum en context klopten niet. De bron was een luchtspiegeling.

- Hans Jonas in München: Een citaat van de Duits-Amerikaanse filosoof werd gelinkt aan een 'rectorale rede' in 1979. Probleem? Jonas was nooit rector in München.

- Paul Verhaeghe's Wijsheid: Zelfs een recente Vlaamse psycholoog moest eraan geloven. Een diepzinnige passage over wijsheid in zijn nieuwste boek bleek Google-onkruid.

Het is belangrijk om hier even bij stil te staan: De Sutter gaf de fout direct toe. Een les die veel politici en CEO’s zouden moeten leren. Ze noemde het een 'goede les' en haalde de zinnen uit de online tekst, al zijn ze nog zichtbaar in de video-opname – mocht je die nog willen bekijken.

De Nasleep: Een Eredoctoraat Ingepakt

De gevolgen waren direct voelbaar. De Sutter zou volgende week een eredoctoraat ontvangen aan de Universiteit van Amsterdam (UvA), een eer voor haar werk in de reproductieve geneeskunde en maatschappelijk engagement. Maar door de ophef heeft ze de eer teruggegeven. Je kunt geen doctoraat ontvangen op basis van verzonnen autoriteit.

Wat mij opviel toen ik dit nieuws zag, is de ongelooflijke druk waaronder we nu opereren. Zelfs topfiguren, die decennialang ervaring in de politiek (vicepremier) en de wetenschap (hoogleraar gynaecologie) hebben, trappen hierin bij het voorbereiden van een speech.

Wat betekent dit voor jouw werk in Nederland?

Dit is geen probleem van de Gentse rector alleen. Denk aan de jaarlijkse presentatie voor je team, of het opstellen van dat belangrijke beleidsstuk. Als je AI een handje laat helpen, werkt het als een snelle, behulpzame stagiair die te veel koffie heeft gedronken: snel, overtuigend, maar af en toe verzint hij de meest fantastische feiten over de Nederlandse woningmarkt of de nieuwste EU-richtlijnen.

De praktische les van UGent: Gebruik AI voor het eerste concept of het omgooien van zinsstructuren, maar laat het nooit de bronvermelding of de kerfles van je argument genereren. Je moet die bronnen dubbelchecken, net zoals je de stoom uit je cappuccino laat ontsnappen voordat je een slok neemt.

De Sutter wilde 'leading by example' zijn in dit technologische tijdperk. Ironisch genoeg heeft ze nu een heel ander voorbeeld gegeven: een waarschuwing. Ze verliet de politiek om zich op academisch leiderschap te richten, maar ontdekte dat de digitale valkuilen overal zijn.

Hoe lang denk jij dat het duurt voordat we een cultuur ontwikkelen waarbij het controleren van AI-output net zo normaal wordt als het checken van je weersvoorspelling voor je naar buiten gaat? Laat het ons weten in de comments!