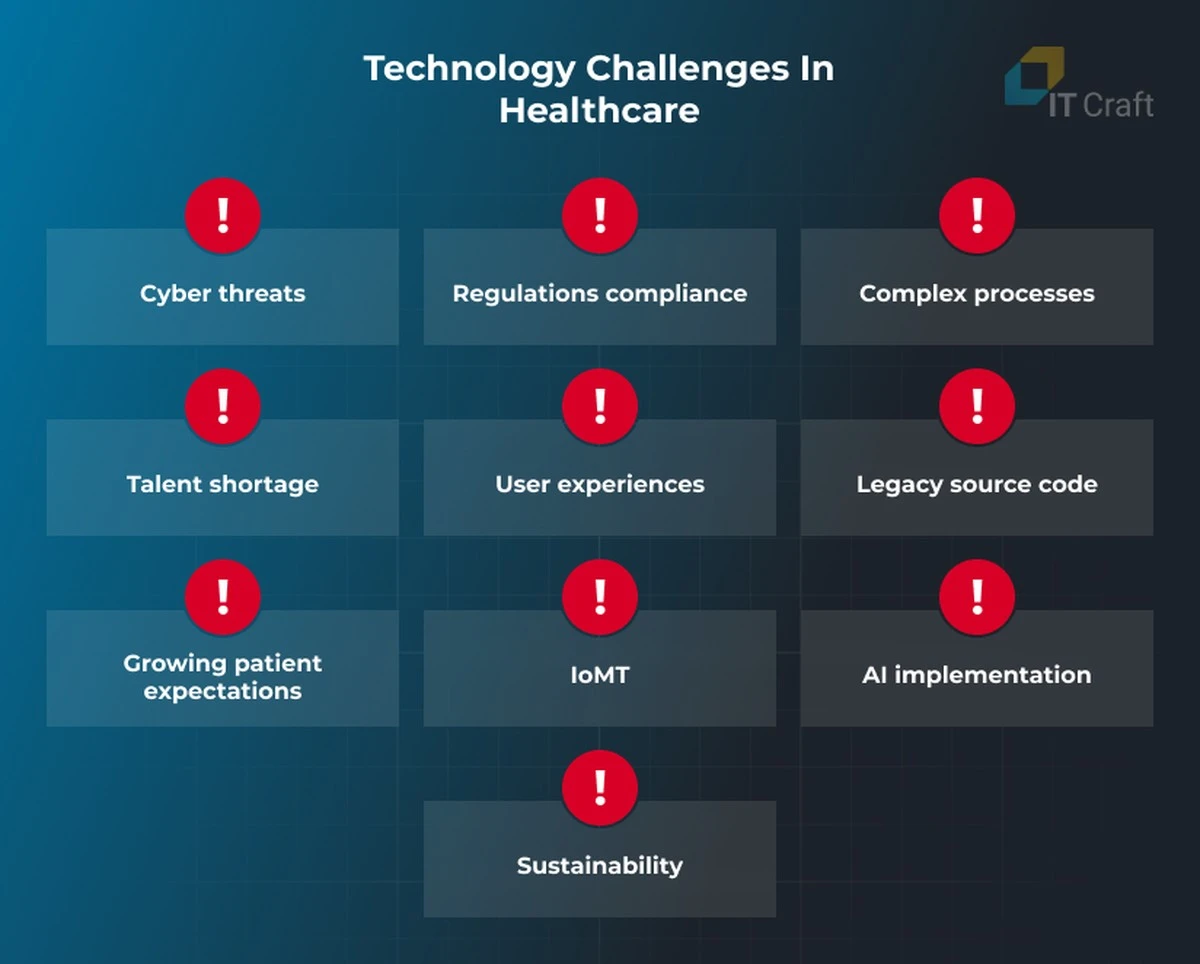

U dacht dat AI de geneeskunde zou revolutioneren? Denk nog eens na. Terwijl OpenAI en Anthropic vol vertrouwen hun medische chatbots lanceren – klaar om dokters te helpen met diagnoses en administratie – houdt Google zich angstvallig stil. Als hun concurrenten nu al de valkuilen van de gezondheidszorg raken, zit u in een moeilijke positie.

Sinds 2011 werkt Big Tech aan de gezondheidszorg, en de praktijk leert dat een 'slimme' algoritme die een verkeerde dosering berekent, niet zomaar een fout is; het is een crisis. De technologische belofte botst met de menselijke angst. We moeten nu begrijpen waarom deze techgiganten, ondanks hun miljardeninvesteringen, de moeilijkste markt nog niet hebben veroverd.

De (vals) veilige lanceringen: Wat we zien bij de concurrentie

OpenAI rolt stilletjes een 'ChatGPT Health'-functie uit, belovend dat het niet voor harde diagnoses bedoeld is. Toch zoeken volgens hen al meer dan 230 miljoen mensen per week gezondheidsadvies via hun app. Dat is een enorm risico dat u als gebruiker loopt, misschien wel terwijl u een ongemak in uw rug analyseert op de bank.

Anthropic pakt het anders aan, met een Claude-versie specifiek voor artsen. Ze trainen deze op medische codes en PubMed-artikelen. Ze beweren dat dit leidt tot een nauwkeurigheid van 99,8% bij het invullen van administratieve codes. **Dat klinkt geruststellend, totdat je naar de echte diagnostische vaardigheden kijkt.**

De 61,3% realiteit: Waar specificiteit faalt

Toen ik Anthropic vroeg naar concrete cijfers over het stellen van diagnoses, bleef het stil. Ze benadrukken hun score van 92,3% op MedCalc (dat gaat over medicijnberekeningen), maar bij de complexere klinische tests, de MedAgentBench, halen ze slechts 61,3%.

- Dat is geen klein foutje; het is alsof een loodgieter bij één op de drie klussen de leidingen verkeerd aansluit.

- Deze modellen zijn geneigd om minder te 'hallucineren' dan die van Google of OpenAI, maar dat is een magere troost als het om uw gezondheid gaat.

- Artsen hebben harde data nodig, geen mooie verhalen over hoe 'eerlijk' het model is bij onzekerheid.

De Google-les: Vertrouwen is duurder dan code

Google weet dit maar al te goed, want zij vochten hier al eerder tegen. Tussen 2008 en 2011 probeerden ze Google Health, een centrale plek voor uw medische dossiers. Het project sneuvelde niet zozeer door de techniek, maar door angst.

Nederlanders, net als veel Europeanen, zijn huiverig. We zien onze medische gegevens liever in de systemen van ons eigen Zorgportaal dan bij een bedrijf dat continu onze zoekopdrachten analyseert voor advertenties. Google had simpelweg een trust-probleem.

Denk aan de schandalen rond DeepMind en Project Nightingale, waarbij Google miljoenen patiëntendossiers in het geheim benaderde. De boodschap was duidelijk: Google is goed in data verzamelen, maar niet in vertrouwen bewaren.

Uw directe risico in de Nederlandse praktijk

Als u nu een AI-tool gebruikt, of uw huisarts deze straks gebruikt, moet u zich realiseren dat de lat voor AI in de zorg elders ligt dan bij het aanbevelen van een nieuw paar schoenen in de sale.

- De 'Hallucinatie Factor': Een AI die een onjuiste diagnose stelt, is niet zomaar een 'bug'. Het kan leiden tot gemiste onderzoeken of onnodige behandelingen.

- Gebrek aan Transparantie: Zolang bedrijven zoals OpenAI en Anthropic weigeren harde cijfers over foutmarges bij *echte* beslissingen te delen, is elke implementatie in het ziekenhuis een gok.

Zelfs de CEO van Anthropic, Dario Amodei, gaf toe dat hij niet wil dat zijn model 'dingen verzint' in de zorg – dat is slecht nieuws. Maar het feit dat ze niet kunnen specificeren hoe vaak dat gebeurt, is eveneens slecht nieuws. De gezondheidszorg wordt de zwaarste AI-test, niet door de complexiteit van de data, maar door de hoge kosten van een simpele, onjuiste letter in de code.

Bent u bereid uw medische vertrouwen te geven aan een algoritme dat u de helft van de tijd correct informeert? Laat ons weten wat uw grootste zorg is bij het idee van een AI-arts.