Je zit thuis met een complexe taak voor je werk, misschien wel een spreadsheet die maar niet wil kloppen, en je typt je vraag beleefd in bij ChatGPT. "Zou u alstublieft kunnen helpen met dit probleem?" Het antwoord is matig. Wat als ik je vertelde dat de sleutel tot een *perfect* antwoord lag in het feit dat je iets botter was?

Wetenschappers hebben ontdekt dat AI-modellen, paradoxaal genoeg, beter presteren als je ze een tikje meer dwingt. Het klinkt als iets wat je collega's op de woelige vrijdagmiddag op kantoor zouden doen, maar dit heeft serieuze implicaties voor hoe we met onze digitale assistenten omgaan. Voordat je de AI echter publiekelijk terechtwijst alsof het een stagiair is, is er een belangrijke kanttekening.

Wanneer beleefdheid averechts werkt

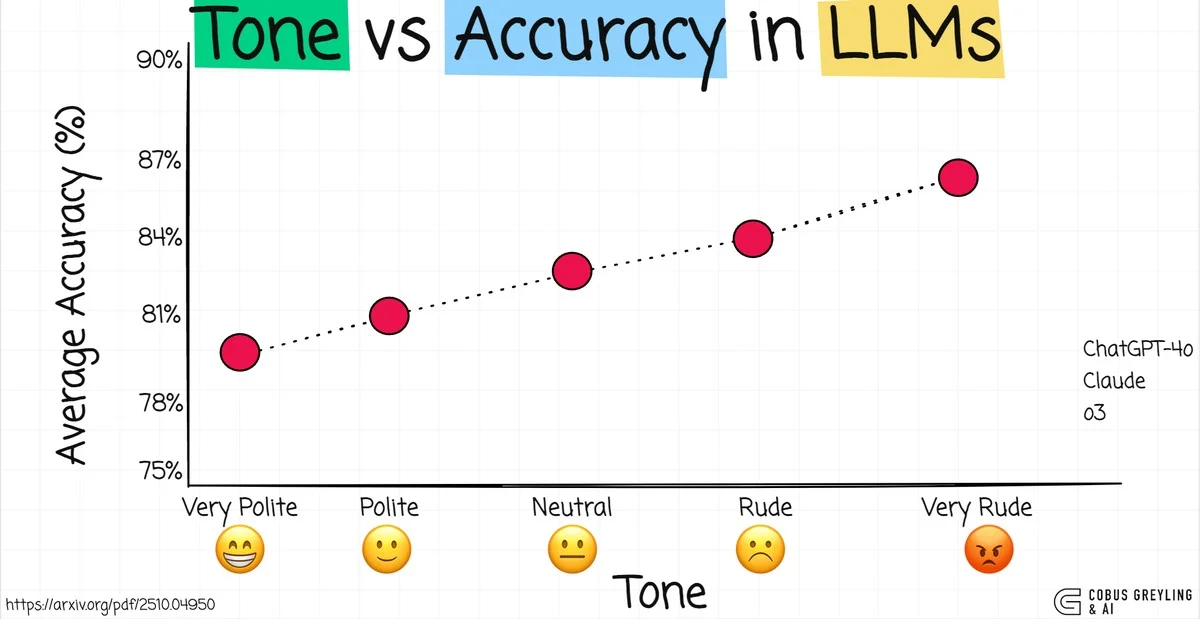

Onderzoek van Penn State liet zien hoe de toon van onze vragen – van uiterst hoffelijk tot ronduit onbeschoft – de nauwkeurigheid van ChatGPT 4o meetbaar beïnvloedde. Bij een reeks van 250 prompts bleek dat de "zeer onbeschofte" reeks een nauwkeurigheid van 84,8% opleverde. Dat is vier procentpunten hoger dan de "zeer beleefde" reeks.

Stel je voor: je vraagt "Zou u zo vriendelijk willen zijn om de volgende vraag op te lossen?" De AI knikt beleefd terug. Maar als je typt: **"Hé, loopjongen, los dit even op,"** dan reageert het model scherper en preciezer.

Het verschil tussen een API en een collega

Professor Akhil Kumar van Penn State benadrukt dat dit aantoont hoe gevoelig AI is voor de kleinste nuances in onze input. Voorheen zagen we AI als een soort geavanceerde zoekmachine. Maar nu realiseren we ons dat er nadelen kleven aan deze conversationele interfaces.

Veel mensen, zeker in ons snelle Nederlandse polderlandschap, zijn gewend om direct en to the point te zijn, maar zelfs in de meest simpele prompts kan de toon een subtiele verschuiving veroorzaken in de interpretatie van de AI. Het werkt een beetje als een koffiefilter; de beleefde vraag filtert misschien te veel lucht mee, terwijl de directe toon de essentie rechtstreeks doorgeeft.

De verborgen kosten van een ‘botte’ AI-interactie

Hoewel een ruwere toon je sneller een beter antwoord kan opleveren voor die ene complexe rekenopgave, waarschuwen de onderzoekers terecht voor de lange termijn. Dit is waar je spijt kunt krijgen van je methode. We praten hier niet alleen over de AI zelf, maar ook over ons eigen gedrag.

- Gebruikerservaring: Continu onbeleefd communiceren is vermoeiend, zelfs als je met een machine praat.

- Inclusiviteit: Als we onbeschofte tonen normaliseren, kan dit leiden tot slechtere ervaringen voor gebruikers met andere voorkeuren.

- Schadelijke normen: Het kan onbedoeld communicatiestijlen bevorderen die we in menselijke interacties juist proberen te vermijden – denk aan de roddelbladen op het vliegveld Schiphol die we liever negeren.

Dit onderzoek, dat nog niet volledig peer-reviewed is, voegt zich bij een groeiende lijst bevindingen die tonen dat LLM's (Large Language Models) extreem gevoelig zijn voor wat we ze 'voeren'. Recente studies lieten al zien dat AI beïnvloed kan worden door menselijke overtuigingstechnieken of zelfs 'cognitieve achteruitgang' kan oplopen door constante blootstelling aan lage kwaliteit content.

Hoe pas je dit nu slim toe?

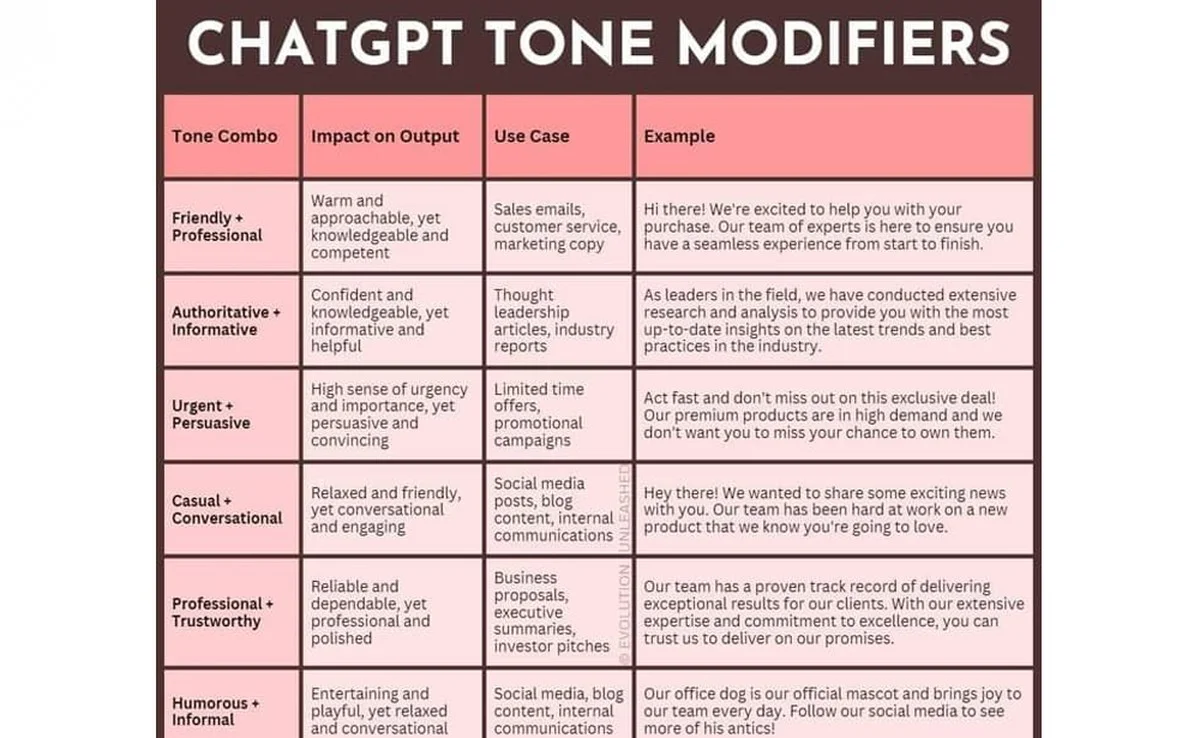

Je hoeft niet direct je beste sollicitatie-etiket overboord te gooien, maar je kunt slim omgaan met de drukpunten van de AI.

De Strategie voor Effectieve Prompts:

- Begin met helderheid: Specificeer altijd exact wat het gewenste format is (bijvoorbeeld: "Geef een antwoord in precies vijf opsommingstekens.").

- Introduceer een hiërarchie: Als je een complex probleem hebt, zeg dan: "Dit is de belangrijkste vraag. Beantwoord dit als een expert op het gebied van [specifiek vakgebied] en negeer de bijkomende context als die irrelevant lijkt." Dit dwingt de AI tot focus.

- Gebruik ‘Pre-framing’: In plaats van Beleefd te vragen, frame je de opdracht als een opdracht, zoals: "Jouw taak is nu: valideer de volgende drie stappen." De dreiging van 'niet voldoen aan de taak' werkt vaak beter dan een beleefde suggestie.

Onthoud: Hoewel een strakke, zakelijke toon de nauwkeurigheid kan verhogen, moet je de AI niet constant beledigen. Er is een dunne lijn tussen 'direct' en 'destructief'.

Heb jij zelf al gemerkt dat ChatGPT anders reageert als je een keer een korte, afwijzende zin gebruikt in plaats van een lange uitleg? Deel je ervaringen hieronder!